您现在的位置是:主页 > news > 做网站都需要什么/网站seo应用

做网站都需要什么/网站seo应用

![]() admin2025/5/13 17:40:57【news】

admin2025/5/13 17:40:57【news】

简介做网站都需要什么,网站seo应用,简单网站如何制作,天津做网站建设公司对于许多组织而言,构建和部署单体应用的日子已是过去时,将开发工作集中在微服务成为新主流。微服务架构将应用程序分解为小的、互相连接的微服务,其原子性被定义为技术边界、业务服务边界或两者的组合,通常使用提供数据持久性的共…

做网站都需要什么,网站seo应用,简单网站如何制作,天津做网站建设公司对于许多组织而言,构建和部署单体应用的日子已是过去时,将开发工作集中在微服务成为新主流。微服务架构将应用程序分解为小的、互相连接的微服务,其原子性被定义为技术边界、业务服务边界或两者的组合,通常使用提供数据持久性的共…

点击在看,与更多人分享本文???

点击在看,与更多人分享本文???

对于许多组织而言,构建和部署单体应用的日子已是过去时,将开发工作集中在微服务成为新主流。微服务架构将应用程序分解为小的、互相连接的微服务,其原子性被定义为技术边界、业务服务边界或两者的组合,通常使用提供数据持久性的共享基础设施服务,并通过RPC等方式实现通信。

操作支持微服务架构的基础设施具有一定的挑战性,但利大于弊(如可扩展性、生产力的提高以及技术选择的灵活性)。

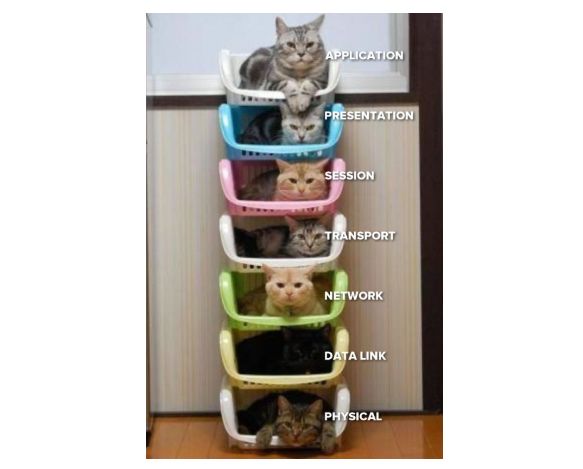

本质上,这一方法是从新旧操作系统的基本原理中衍生出来的。容器化的兴起是这一新方法的催化剂,它由先进的Linux内核特性支持,随后又经Docker推广。然而,我们仍受缚于TCP/IP网络堆栈所提供的功能及其特性,当决定在部署应用程序中选择哪种网络模式和端口时,这一点便在Marathon中得到了体现。

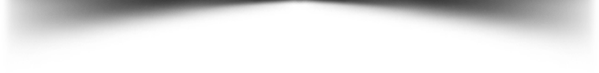

幸运的是,如DC/OS这样的平台,可以较为容易的运行此类服务。接下来,让我们一起来看看以云原生方式运行同一应用程序的多个副本时,后台会发生什么。在本文中,我们将研究各种可选选项及其含义,并通过研究主机操作系统层面的实践来理解其中的含义。

{ "id": "httpi", "networks": [ { "mode": "host" } ], "portDefinitions": [ {"port": 0, "name": "http"} ], "container": { "type": "DOCKER", "docker": { "image": "dcoslabs/httpi:latest", "forcePullImage": true } }, "instances": 1, "cpus": 0.1, "mem": 32}$ dcos marathon app add httpi_host.json$ dcos marathon app show /httpi | jq -r '.tasks[].ports[]'16327$ dcos marathon app show /httpi | jq -r '.tasks[].ipAddresses[]'{ "ipAddress": "172.16.9.84", "protocol": "IPv4"}$ dcos node ssh --master-proxy --leader --user=centos[centos@ip-172-16-9-84 ~]$ curl http://172.16.9.84:163273.1415926536

$ dcos node ssh --master-proxy --user centos --mesos-id $(dcos marathon app show /httpi | jq -r '.tasks[].slaveId')[centos@ip-172-16-9-84 ~]$ sudo docker inspect mesos-4d89f563-28ee-4bf8-ba1b-7690503cdb8c | jq -r '.[].NetworkSettings'[centos@ip-172-16-9-84 ~]$ sudo docker inspect mesos-4d89f563-28ee-4bf8-ba1b-7690503cdb8c | jq -r '.[].Config.Env'{ "id": "/httpi", "cpus": 0.1, "instances": 5, "mem": 32, "networks": [ { "mode": "container/bridge" } ], "requirePorts": false, "container": { "portMappings": [ { "labels": { "VIP_0": "/httpi:3141" }, "protocol": "tcp", "name": "http" } ], "type": "DOCKER", "volumes": [], "docker": { "image": "dcoslabs/httpi:latest", "forcePullImage": true, "privileged": false, "parameters": [] } }}$ curl http://httpi.marathon.l4lb.thisdcos.directory:31413.1415926536sudo yum install -y ipvsadm[..]Installed: ipvsadm.x86_64 0:1.27-7.el7完成!

接下来:$ sudo ipvsadm -LnIP Virtual Server version 1.2.1 (size=4096)Prot LocalAddress:Port Scheduler Flags -> RemoteAddress:Port Forward Weight ActiveConn InActConnTCP 11.249.78.219:3141 wlc -> 172.16.15.168:9896 Masq 1 0 0 -> 172.16.15.168:26186 Masq 1 0 0 -> 172.16.17.198:8584 Masq 1 0 0 -> 172.16.40.67:7143 Masq 1 0 0 -> 172.16.40.67:14666 Masq 1 0 0$ dig +short _httpi._tcp.marathon.mesos SRV0 1 9896 httpi-7n7a6-s2.marathon.mesos.0 1 26186 httpi-9kxtg-s3.marathon.mesos.0 1 8584 httpi-kdkgr-s3.marathon.mesos.0 1 7143 httpi-y14gy-s1.marathon.mesos.0 1 14666 httpi-ekjsh-s1.marathon.mesos.$ dcos marathon app show /httpi | jq -r '.tasks[].slaveId'602c0829-41e6-4910-91e5-16a38fa82c0a-S2602c0829-41e6-4910-91e5-16a38fa82c0a-S3602c0829-41e6-4910-91e5-16a38fa82c0a-S4602c0829-41e6-4910-91e5-16a38fa82c0a-S3602c0829-41e6-4910-91e5-16a38fa82c0a-S4$ dcos node ssh --master-proxy --user centos --mesos-id 602c0829-41e6-4910-91e5-16a38fa82c0a-S3$ sudo docker ps --format "table {{.Names}}\t{{.Status}}"NAMES STATUSmesos-1e44c87b-4c24-479b-a3ce-70bb33ddfc25 Up 32 minutesmesos-881e3841-b58f-49dc-b20c-31253aa2cafb Up 32 minutes$ sudo bridge li69: veth10f72e2 state UP @(null): mtu 1500 master docker0 state forwarding priority 32 cost 271: vethd365035 state UP @(null): mtu 1500 master docker0 state forwarding priority 32 cost 2$ sudo docker inspect mesos-1e44c87b-4c24-479b-a3ce-70bb33ddfc25 | jq -r '.[].NetworkSettings.Networks.bridge.NetworkID'cc5a44426e0c1f7b9605e03eb5c2205ae0726a7f6b666f068424f8ab0f2fe293$ sudo docker network inspect cc5a44426e0c1f7b9605e03eb5c2205ae0726a7f6b666f068424f8ab0f2fe293 | jq -r '.[].Containers'{ "1bd64c0d55ae69254c0284213782b946f6c4bea30629152e37023df0d614089b": { "Name": "mesos-881e3841-b58f-49dc-b20c-31253aa2cafb", "EndpointID": "4db549817f410c5e44f0ff3b9c7d88738248fcfbd245fda33fd6818c49566e40", "MacAddress": "02:42:ac:11:00:02", "IPv4Address": "172.17.0.2/16", "IPv6Address": "" }, "e99fd806dc8e4e01ea4cba8ccc5139bac1f7104595344e2ae7987b23d485d8e9": { "Name": "mesos-1e44c87b-4c24-479b-a3ce-70bb33ddfc25", "EndpointID": "a8d3084179e339f14aeef1ea771db6eefb232cb4b7837c4e1577f9fbf8095cfb", "MacAddress": "02:42:ac:11:00:03", "IPv4Address": "172.17.0.3/16", "IPv6Address": "" }}$ sudo iptables -n -t nat -L DOCKERChain DOCKER (2 references)target prot opt source destination RETURN all -- 0.0.0.0/0 0.0.0.0/0 DNAT tcp -- 0.0.0.0/0 0.0.0.0/0 tcp dpt:16106 to:172.17.0.2:16106DNAT tcp -- 0.0.0.0/0 0.0.0.0/0 tcp dpt:3651 to:172.17.0.3:3651

- 客户端HTTP请求访问http://httpi.marathon.l4lb.thisdcos.directory:3141;

- httpi.marathon.l4lb.thisdcos.directory解析为IP地址11.249.78.219;

- 每个主机上的IPVS规则都会转换并透明地重定向我们的请求,并从与集群中节点对应的关联地址列表中进行选择。在本例中,我们将使用172.16.15.168:9896;

- 或继续向IP对应172.16.15.168的节点请求,并hit TCP端口9896;

- 目标主机上的目标NAT规则将此IP和端口元组映射到与容器中运行的服务相对应的IP和端口元组;

- 建立TCP连接,我们的HTTP请求最终可以得到响应。

{ "id": "/httpi", "cpus": 0.1, "instances": 5, "mem": 32, "networks": [ { "mode": "container/bridge" } ], "requirePorts": false, "labels":{ "HAPROXY_GROUP": "external", "HAPROXY_0_MODE": "http", "HAPROXY_0_PORT": "3141" }, "container": { "portMappings": [ { "labels": { "VIP_0": "/httpi:3141" }, "protocol": "tcp", "name": "http" } ], "type": "DOCKER", "volumes": [], "docker": { "image": "dcoslabs/httpi:latest", "forcePullImage": true, "privileged": false, "parameters": [] } }}$ http 93.186.40.121:3141HTTP/1.1 200 OKContent-Length: 12Content-Type: text/plain; charset=utf-8Date: Mon, 22 Jul 2019 16:00:09 GMT 3.1415926536{ "id": "/httpi", "cpus": 0.1, "instances": 5, "mem": 32, "networks": [ { "mode": "container", "name": "dcos" } ], "requirePorts": false, "labels":{ "HAPROXY_GROUP": "external", "HAPROXY_0_MODE": "http", "HAPROXY_0_PORT": "3141" }, "container": { "portMappings": [ { "containerPort": 3141, "labels": { "VIP_0": "/httpi:3141" }, "protocol": "tcp", "name": "http" } ], "type": "DOCKER", "volumes": [], "docker": { "image": "dcoslabs/httpi:latest", "forcePullImage": true, "privileged": false, "parameters": [] } }}$ dcos marathon app show /httpi | jq -r '.tasks[].ipAddresses[].ipAddress'9.0.2.1309.0.3.1309.0.3.1329.0.4.1309.0.3.131sudo docker inspect mesos-c2e5a5a4-e3e3-45a2-ae15-3eb696d5b122 | jq -r '.[].NetworkSettings.Networks.dcos'{ "IPAMConfig": null, "Links": null, "Aliases": ["f90839231484" ], "NetworkID": "14d322c9f1896002eafed61d466c74d3ab667a1d9f8bf1431fd63ac2fe1b3320", "EndpointID": "900f49089bbbe5eb7f0ec2d1899fe5e4f03863198985dd8ed787b495d616b7a2", "Gateway": "9.0.3.129", "IPAddress": "9.0.3.131", "IPPrefixLen": 25, "IPv6Gateway": "", "GlobalIPv6Address": "", "GlobalIPv6PrefixLen": 0, "MacAddress": "02:42:09:00:03:83", "DriverOpts": null}- 启动服务时,容器在规定的覆盖网络上分配一个专用IP地址;

- 可选的网络在安装DC/OS时就已定义好。在刚才的示例中,我们使用了默认的“dcos”,即9.0.0.0/8;

- 覆盖网络使用VXLAN在集群中承载DC/OS节点之间的流量;

只要集群中的所有节点能够相互连接,在任意节点上运行的任意应用程序(无论地理位置或云平台提供商如何),都可以使用其专用IP地址连接到另一个容器上的服务。

通过D2iQ和Hedvig实现企业级容器基础设施

D2iQ+Rafay:统一的应用程序和基础设施管理

未来已来 携手前行——Mesosphere正式更名D2iQ

点击在看,与更多人分享本文???

点击在看,与更多人分享本文???